1. Thời niên thiếu và Giáo dục

Thời niên thiếu và quá trình học vấn của Timnit Gebru, đặc biệt là những trải nghiệm cá nhân về di cư và phân biệt chủng tộc, đã định hình sâu sắc mối quan tâm của bà đối với đạo đức công nghệ và tác động xã hội của AI.

1.1. Xuất thân và Bối cảnh

Gebru sinh ra và lớn lên ở Addis Ababa, Ethiopia. Cả cha và mẹ bà đều có nguồn gốc từ Eritrea. Cha bà, một kỹ sư điện có bằng Tiến sĩ, qua đời khi bà mới năm tuổi, và bà được mẹ, một nhà kinh tế học, nuôi dưỡng.

1.2. Di cư và Trải nghiệm tại Hoa Kỳ

Năm 15 tuổi, trong bối cảnh Chiến tranh Eritrea-Ethiopia, Gebru đã phải rời Ethiopia sau khi một số thành viên gia đình bà bị trục xuất về Eritrea và bị buộc phải tham gia chiến đấu trong chiến tranh. Ban đầu, bà bị từ chối cấp Thị thực Hoa Kỳ và phải sống một thời gian ngắn ở Ireland, nhưng cuối cùng bà đã nhận được tị nạn chính trị tại Hoa Kỳ. Bà mô tả trải nghiệm này là "khốn khổ". Gebru định cư tại Somerville, Massachusetts, để theo học trung học, nơi bà cho biết mình ngay lập tức phải đối mặt với phân biệt chủng tộc. Một số giáo viên đã từ chối cho bà tham gia các khóa học Advanced Placement nhất định, mặc dù bà là một học sinh xuất sắc.

Sau khi tốt nghiệp trung học, một sự cố với cảnh sát đã đưa Gebru đến với việc tập trung vào đạo đức trong công nghệ. Một người bạn của bà, một phụ nữ da đen, bị hành hung trong một quán bar, và Gebru đã gọi cảnh sát để báo cáo. Tuy nhiên, thay vì lập báo cáo về vụ hành hung, người bạn của bà lại bị bắt giữ và tạm giam. Gebru gọi đây là một khoảnh khắc then chốt và là một "ví dụ trắng trợn về phân biệt chủng tộc có hệ thống", từ đó khơi dậy sự quan tâm sâu sắc của bà đến các vấn đề đạo đức trong công nghệ.

1.3. Học vấn và Khởi đầu sự nghiệp nghiên cứu

Năm 2001, Gebru được nhận vào Đại học Stanford. Tại đây, bà đã hoàn thành bằng Cử nhân và Thạc sĩ kỹ thuật điện. Sau đó, bà tiếp tục lấy bằng Tiến sĩ về thị giác máy tính vào năm 2017 dưới sự hướng dẫn của Giáo sư Fei-Fei Li.

Trong quá trình học tiến sĩ, Gebru đã thực tập tại Apple Inc. từ năm 2004 đến 2013, làm việc trong bộ phận phần cứng để chế tạo mạch điện cho các linh kiện âm thanh và được đề nghị một vị trí toàn thời gian vào năm sau. Bà được mô tả là "không sợ hãi" và được đồng nghiệp yêu mến. Trong thời gian làm việc tại Apple, Gebru bắt đầu quan tâm nhiều hơn đến việc phát triển phần mềm, đặc biệt là thị giác máy tính có khả năng phát hiện hình người. Bà đã phát triển các thuật toán xử lý tín hiệu cho chiếc iPad đầu tiên. Vào thời điểm đó, bà cho biết mình không xem xét khả năng sử dụng cho mục đích giám sát, mà chỉ thấy nó "thú vị về mặt kỹ thuật".

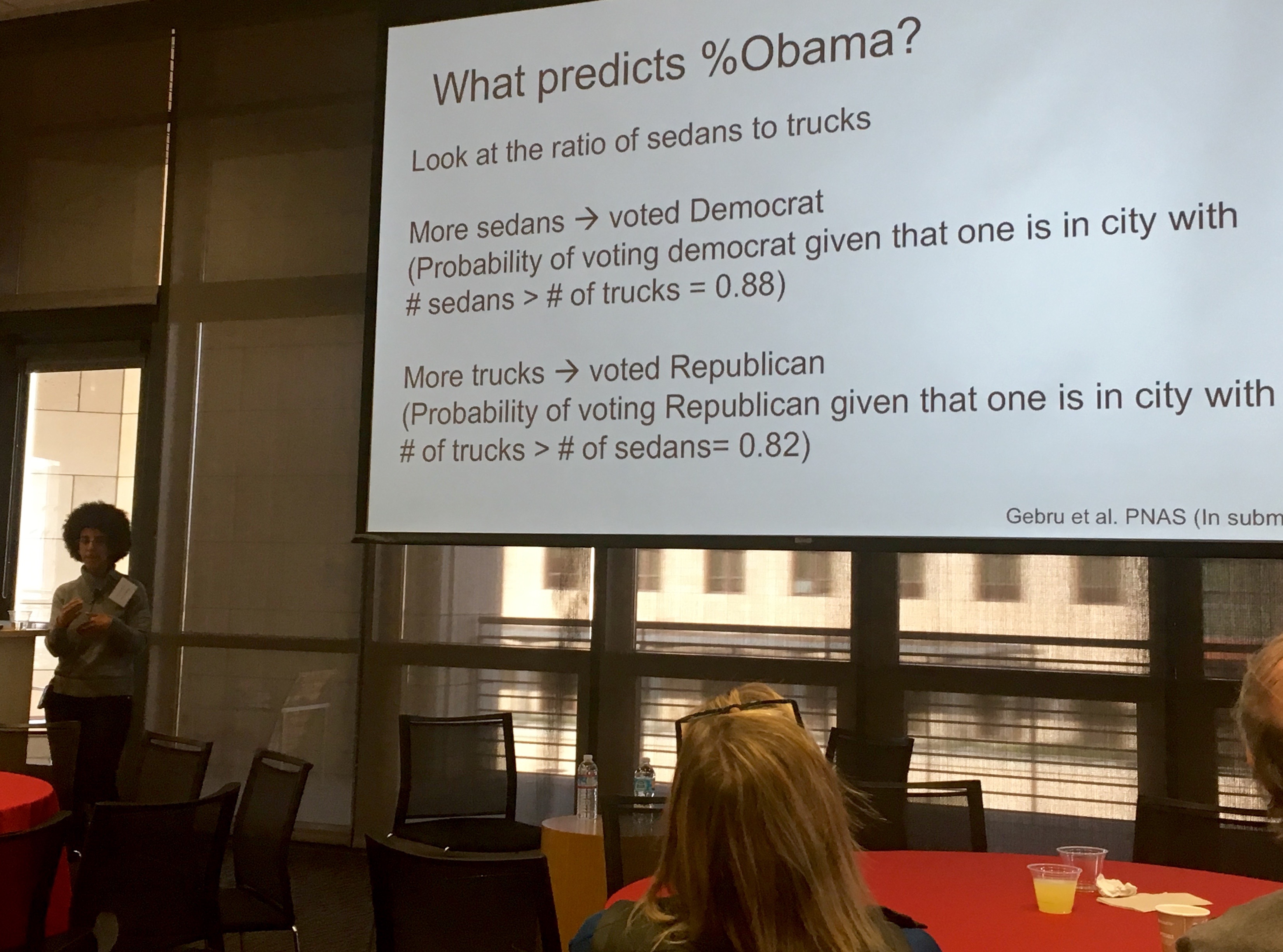

Nghiên cứu tiến sĩ của Gebru tập trung vào việc sử dụng khai phá dữ liệu từ các hình ảnh công khai. Bà quan tâm đến lượng tiền mà các tổ chức chính phủ và phi chính phủ chi để thu thập thông tin về các cộng đồng. Để tìm kiếm các giải pháp thay thế, Gebru đã kết hợp học sâu với Google Street View để ước tính nhân khẩu học của các khu phố ở Hoa Kỳ. Nghiên cứu của bà cho thấy các thuộc tính kinh tế xã hội như mô hình bầu cử, thu nhập, chủng tộc và giáo dục có thể được suy ra từ việc quan sát các loại xe ô tô. Ví dụ, nếu số lượng xe bán tải nhiều hơn số lượng xe sedan, cộng đồng đó có nhiều khả năng bỏ phiếu cho Đảng Cộng hòa. Nhóm của bà đã phân tích hơn 15 triệu hình ảnh từ 200 thành phố đông dân nhất Hoa Kỳ. Công trình này đã được nhiều phương tiện truyền thông lớn đưa tin, bao gồm BBC News, Newsweek, The Economist và The New York Times.

Năm 2017, Gebru đã trình bày nghiên cứu tiến sĩ của mình tại cuộc thi LDV Capital Vision Summit, nơi các nhà khoa học thị giác máy tính trình bày công trình của họ trước các thành viên ngành công nghiệp và các nhà đầu tư mạo hiểm. Gebru đã giành chiến thắng trong cuộc thi này, mở ra một loạt các hợp tác với các doanh nhân và nhà đầu tư khác.

Trong thời gian học tiến sĩ vào năm 2016 và sau đó vào năm 2018, Gebru đã trở lại Ethiopia cùng với chiến dịch lập trình AddisCoder của Jelani Nelson. Trong một bài báo chưa được xuất bản viết trong thời gian học tiến sĩ, Gebru đã bày tỏ lo ngại về tương lai của AI, đặc biệt là những nguy hiểm từ việc thiếu sự đa dạng trong lĩnh vực này, dựa trên những trải nghiệm của bà với cảnh sát và một cuộc điều tra của ProPublica về dự đoán tội phạm, vốn đã tiết lộ sự phản ánh các thiên vị của con người trong học máy. Trong bài báo, bà đã chỉ trích "văn hóa câu lạc bộ nam giới", kể lại những trải nghiệm bị quấy rối tình dục bởi những người tham dự nam giới say xỉn tại các hội nghị, và phê phán việc tôn sùng các nhân vật nổi tiếng trong lĩnh vực này.

2. Sự nghiệp và Hoạt động

Sự nghiệp của Timnit Gebru trải dài qua các tập đoàn công nghệ lớn như Apple và Microsoft, trước khi bà trở thành một tiếng nói hàng đầu về đạo đức AI tại Google và sau đó thành lập viện nghiên cứu độc lập của riêng mình.

2.1. Sự nghiệp ban đầu (Apple, Microsoft)

Như đã đề cập, Gebru đã làm việc tại Apple Inc. từ năm 2004 đến 2013, ban đầu là thực tập sinh và sau đó là kỹ sư toàn thời gian. Bà tập trung vào việc phát triển các thuật toán xử lý tín hiệu cho iPad đầu tiên và dần chuyển sang quan tâm đến việc xây dựng phần mềm thị giác máy tính. Nhiều năm sau khi rời Apple, trong phong trào AppleToo vào mùa hè năm 2021, Gebru tiết lộ rằng bà đã trải qua "rất nhiều điều tồi tệ" tại công ty và "luôn tự hỏi làm thế nào họ có thể thoát khỏi sự chú ý của công chúng". Bà cho rằng trách nhiệm giải trình tại Apple đã quá hạn từ lâu và cảnh báo rằng họ không thể tiếp tục "bay dưới tầm radar" lâu hơn nữa. Gebru cũng chỉ trích cách giới truyền thông đưa tin về Apple và các gã khổng lồ công nghệ khác, cho rằng báo chí đã giúp che chắn các công ty này khỏi sự giám sát của công chúng.

Năm 2013, Gebru gia nhập phòng thí nghiệm của Fei-Fei Li tại Stanford, nơi bà tiếp tục nghiên cứu về khai phá dữ liệu từ hình ảnh công khai. Vào mùa hè năm 2017, Gebru gia nhập Microsoft với tư cách là nhà nghiên cứu sau tiến sĩ trong phòng thí nghiệm Công bằng, Trách nhiệm, Minh bạch và Đạo đức trong AI (FATE). Trong một cuộc phỏng vấn với MIT Technology Review vào năm 2017, Gebru đã thảo luận về những thiên vị tồn tại trong các hệ thống AI và cách việc tăng cường sự đa dạng trong các nhóm AI có thể khắc phục vấn đề đó. Bà chỉ ra rằng những thiên vị này thường bắt nguồn từ chính các nhà phát triển phần mềm. Khi còn ở Microsoft, Gebru đã đồng tác giả một bài nghiên cứu mang tên Gender Shades, mở đường cho một dự án rộng lớn hơn của Viện Công nghệ Massachusetts do đồng tác giả Joy Buolamwini dẫn đầu. Cặp đôi này đã điều tra phần mềm nhận dạng khuôn mặt và phát hiện ra rằng trong một triển khai cụ thể, phụ nữ da đen có khả năng được nhận dạng thấp hơn 35% so với nam giới da trắng.

2.2. Nghiên cứu Đạo đức AI tại Google

Gebru gia nhập Google vào năm 2018, nơi bà đồng lãnh đạo một nhóm về đạo đức trí tuệ nhân tạo cùng với Margaret Mitchell. Bà tập trung nghiên cứu những tác động của trí tuệ nhân tạo, tìm cách cải thiện khả năng của công nghệ để mang lại lợi ích xã hội.

Năm 2019, Gebru và các nhà nghiên cứu AI khác đã ký một lá thư kêu gọi Amazon ngừng bán công nghệ nhận dạng khuôn mặt của mình cho các cơ quan thực thi pháp luật, với lý do công nghệ này có thiên vị đối với phụ nữ và người da màu. Họ đã trích dẫn một nghiên cứu do các nhà nghiên cứu MIT thực hiện cho thấy hệ thống nhận dạng khuôn mặt của Amazon gặp nhiều khó khăn hơn trong việc xác định phụ nữ da sẫm màu so với phần mềm nhận dạng khuôn mặt của bất kỳ công ty công nghệ nào khác. Trong một cuộc phỏng vấn với The New York Times, Gebru còn bày tỏ quan điểm rằng bà tin rằng công nghệ nhận dạng khuôn mặt hiện tại quá nguy hiểm để được sử dụng cho mục đích thực thi pháp luật và an ninh.

2.3. Bài báo "Vẹt Ngẫu nhiên" và việc rời Google

Năm 2020, Gebru và năm đồng tác giả (trong đó bốn người cũng làm việc tại Google) đã viết một bài báo có tựa đề "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜" (Về những nguy hiểm của Vẹt Ngẫu nhiên: Liệu các mô hình ngôn ngữ có thể quá lớn?). Bài báo này đã xem xét các rủi ro của các mô hình ngôn ngữ lớn (LLM), bao gồm dấu chân môi trường, chi phí tài chính, tính khó hiểu của các mô hình lớn (dẫn đến những thiên vị tiềm ẩn nguy hiểm), khả năng LLM hiển thị định kiến chống lại các nhóm nhất định, sự bất lực của LLM trong việc hiểu ngôn ngữ mà chúng xử lý, và khả năng sử dụng LLM để lan truyền thông tin sai lệch.

Vào tháng 12 năm 2020, việc làm của bà tại Google đã chấm dứt sau khi ban quản lý Google yêu cầu bà rút bài báo trước khi xuất bản, hoặc xóa tên của tất cả các tác giả là nhân viên Google khỏi bài báo. Trong số sáu tác giả, chỉ có Emily M. Bender là không phải nhân viên của Google vào thời điểm đó. Trong một email dài sáu trang gửi đến một danh sách hợp tác nội bộ, Gebru mô tả cách bà được triệu tập đến một cuộc họp gấp, nơi bà được yêu cầu rút bài báo. Bà đã yêu cầu được biết danh tính và phản hồi của từng người đánh giá đã đưa ra quyết định này, cùng với lời khuyên về cách sửa đổi bài báo theo ý muốn của Google. Bà tuyên bố rằng nếu Google từ chối cung cấp thông tin đó, bà sẽ nói chuyện với quản lý của mình về "ngày kết thúc làm việc". Google đã chấm dứt hợp đồng lao động của bà ngay lập tức, tuyên bố rằng họ chấp nhận đơn từ chức của bà. Tuy nhiên, Gebru khẳng định rằng bà chưa chính thức đề nghị từ chức, mà chỉ đe dọa sẽ làm như vậy.

Jeff Dean, người đứng đầu bộ phận nghiên cứu AI của Google, đã phản hồi bằng một email nội bộ, nói rằng quyết định này được đưa ra vì bài báo đã bỏ qua quá nhiều nghiên cứu gần đây có liên quan về các cách giảm thiểu một số vấn đề được mô tả trong đó, liên quan đến tác động môi trường và thiên vị của các mô hình này. Dean sau đó đã công khai email nội bộ của mình về việc Gebru rời đi và những suy nghĩ của ông về vấn đề này, bảo vệ quy trình xuất bản bài nghiên cứu của Google nhằm "giải quyết các vấn đề tham vọng, nhưng phải làm điều đó một cách có trách nhiệm". Gebru và những người khác cho rằng việc công bố ban đầu này, cùng với sự im lặng sau đó của Dean về vấn đề, đã "xúc tác và cho phép" những hành vi quấy rối tiếp theo. Gebru đã bị quấy rối liên tục bởi một số tài khoản giả mạo và internet troll trên Twitter, với những bình luận phân biệt chủng tộc và tục tĩu. Gebru và những người ủng hộ bà cáo buộc rằng một số hành vi quấy rối đến từ nhà nghiên cứu học máy Pedro Domingos và doanh nhân Michael Lissack, người đã nói rằng công trình của bà là "sự vận động ngụy trang dưới dạng khoa học". Lissack cũng bị cáo buộc quấy rối Mitchell và Bender, cùng với các đồng nghiệp khác trong nhóm cũ của Gebru. Twitter đã tạm thời đình chỉ quyền truy cập tài khoản của Lissack vào ngày 1 tháng 2 năm 2021.

Gebru đã nhiều lần khẳng định rằng bà đã bị sa thải. Gần 2.700 nhân viên Google và hơn 4.300 học giả cùng những người ủng hộ xã hội dân sự đã ký một lá thư lên án việc Gebru bị sa thải. Chín thành viên Quốc hội Hoa Kỳ đã gửi một lá thư tới Google yêu cầu làm rõ hoàn cảnh rời đi của Timnit Gebru. Nhóm cũ của Gebru yêu cầu Phó Chủ tịch Megan Kacholia bị loại khỏi chuỗi quản lý của nhóm. Kacholia bị cáo buộc đã sa thải Gebru mà không thông báo trước cho quản lý trực tiếp của Gebru là Samy Bengio. Nhóm cũ của Gebru yêu cầu Kacholia và Dean phải xin lỗi về cách Gebru bị đối xử. Margaret Mitchell, đồng lãnh đạo nhóm của Gebru, đã lên Twitter để chỉ trích cách Google đối xử với các nhân viên làm việc để loại bỏ thiên vị và độc hại trong AI, bao gồm cả việc cáo buộc sa thải Gebru. Mitchell sau đó cũng bị chấm dứt hợp đồng vì bị cáo buộc đã đánh cắp các tài liệu nhạy cảm kinh doanh mật và dữ liệu cá nhân của các nhân viên khác.

Sau những phản ứng tiêu cực về hoàn cảnh bà rời đi, Sundar Pichai, Tổng giám đốc điều hành của Alphabet (công ty mẹ của Google), đã công khai xin lỗi trên Twitter mà không làm rõ liệu Gebru bị chấm dứt hợp đồng hay tự nguyện từ chức, và đã khởi xướng một cuộc điều tra kéo dài nhiều tháng về vụ việc. Khi cuộc điều tra kết thúc, Dean thông báo rằng Google sẽ thay đổi "cách tiếp cận trong việc xử lý việc một số nhân viên rời công ty", nhưng vẫn không làm rõ liệu việc Gebru rời Google là tự nguyện hay không. Ngoài ra, Dean cho biết sẽ có những thay đổi về cách các bài nghiên cứu với chủ đề "nhạy cảm" sẽ được xem xét, và các mục tiêu về đa dạng, công bằng và hòa nhập (DEI) sẽ được báo cáo cho hội đồng quản trị của Alphabet hàng quý. Gebru đã viết trên Twitter rằng bà "không mong đợi gì hơn" từ Google và chỉ ra rằng những thay đổi này là do những yêu cầu mà bà bị cáo buộc đã bị chấm dứt hợp đồng vì chúng, nhưng không ai phải chịu trách nhiệm về việc đó. Sau vụ việc, hai nhân viên Google đã từ chức.

Sau khi Gebru rời đi, Google đã tổ chức một diễn đàn để thảo luận về những trải nghiệm phân biệt chủng tộc tại công ty. Các nhân viên đã báo cáo với NBC News rằng một nửa thời gian của diễn đàn được dành để làm mất uy tín của Gebru, điều mà họ coi là công ty đang dùng bà làm gương cho việc lên tiếng. Diễn đàn này sau đó được tiếp nối bằng một buổi liệu pháp nhóm cho các nhân viên da đen của Google với một nhà trị liệu được cấp phép, điều mà các nhân viên cho rằng đã bỏ qua những tổn hại mà họ cảm thấy việc Gebru bị sa thải đã gây ra.

2.4. Thành lập Viện Nghiên cứu Trí tuệ Nhân tạo Phân tán (DAIR)

Vào tháng 6 năm 2021, Gebru thông báo rằng bà đang huy động vốn để "thành lập một viện nghiên cứu độc lập mô phỏng theo công việc của bà trong nhóm AI Đạo đức của Google và kinh nghiệm của bà trong Black in AI".

Vào ngày 2 tháng 12 năm 2021, bà đã chính thức ra mắt Viện Nghiên cứu Trí tuệ Nhân tạo Phân tán (DAIR). Mục tiêu của DAIR là ghi lại tác động của trí tuệ nhân tạo đối với các nhóm bị thiệt thòi, tập trung vào châu Phi và những người nhập cư châu Phi ở Hoa Kỳ. Một trong những dự án ban đầu của tổ chức này là phân tích hình ảnh vệ tinh của các thị trấn ở Nam Phi bằng AI để hiểu rõ hơn về di sản của chế độ apartheid.

3. Lĩnh vực Nghiên cứu và Đóng góp Chính

Timnit Gebru đã có những đóng góp đáng kể trong việc làm sáng tỏ các vấn đề đạo đức và xã hội của trí tuệ nhân tạo, đặc biệt là về thiên vị thuật toán, công nghệ nhận dạng khuôn mặt và rủi ro của các mô hình ngôn ngữ lớn.

3.1. Thiên vị Thuật toán và Sự Công bằng

Gebru đã dành phần lớn nghiên cứu của mình để xác định và giảm thiểu thiên vị tồn tại trong các hệ thống AI. Công trình tiến sĩ của bà, sử dụng học sâu và dữ liệu từ Google Street View để dự đoán nhân khẩu học, đã chứng minh cách các đặc điểm kinh tế xã hội có thể được suy ra từ dữ liệu công khai, đồng thời nêu bật tiềm năng của thiên vị trong quá trình thu thập và phân tích dữ liệu. Bà đã liên tục chỉ ra rằng những thiên vị này thường xuất phát từ chính những người phát triển phần mềm và dữ liệu huấn luyện, dẫn đến hệ thống AI có thể củng cố hoặc thậm chí làm trầm trọng thêm các bất bình đẳng xã hội hiện có.

3.2. Công nghệ Nhận dạng Khuôn mặt và Chênh lệch Giới/Chủng tộc

Một trong những đóng góp nổi bật nhất của Gebru là dự án Gender Shades, một công trình nghiên cứu mà bà đồng tác giả với Joy Buolamwini. Dự án này đã điều tra các hệ thống nhận dạng khuôn mặt thương mại và phát hiện ra sự khác biệt đáng kể về độ chính xác theo giới tính và chủng tộc. Cụ thể, nghiên cứu chỉ ra rằng các hệ thống này gặp khó khăn hơn trong việc nhận dạng phụ nữ da đen, với độ chính xác thấp hơn 35% so với nam giới da trắng trong một số trường hợp.

Công trình này không chỉ làm sáng tỏ vấn đề thiên vị thuật toán mà còn thúc đẩy các cuộc thảo luận rộng rãi về việc sử dụng công nghệ nhận dạng khuôn mặt trong các ứng dụng nhạy cảm như thực thi pháp luật. Gebru đã ký một lá thư kêu gọi Amazon ngừng bán công nghệ nhận dạng khuôn mặt của mình cho các cơ quan thực thi pháp luật vì những lo ngại về thiên vị. Bà cũng bày tỏ quan điểm rằng công nghệ nhận dạng khuôn mặt hiện tại quá nguy hiểm để được sử dụng cho mục đích thực thi pháp luật và an ninh.

3.3. Rủi ro của Mô hình Ngôn ngữ Lớn (LLM)

Bài báo "On the Dangers of Stochastic Parrots: Can Language Models Be Too Big? 🦜", đồng tác giả của Gebru, đã phân tích sâu rộng các rủi ro tiềm ẩn của các mô hình ngôn ngữ lớn (LLM). Các rủi ro chính được nêu bật bao gồm:

- Dấu chân môi trường và chi phí tài chính: Việc đào tạo và vận hành các LLM khổng lồ tiêu tốn một lượng lớn năng lượng và tài nguyên tính toán, gây ra tác động đáng kể đến môi trường và chi phí tài chính cao.

- Tính khó hiểu và thiên vị: Do kích thước và độ phức tạp của chúng, các LLM thường hoạt động như "hộp đen", khiến việc hiểu cách chúng đưa ra quyết định trở nên khó khăn. Điều này có thể dẫn đến việc các thiên vị nguy hiểm, khó lường được nhúng vào mô hình.

- Thiếu hiểu biết khái niệm: Mặc dù có khả năng tạo ra văn bản mạch lạc, các LLM không thực sự "hiểu" ngôn ngữ hoặc các khái niệm cơ bản mà chúng xử lý. Chúng chỉ là "vẹt ngẫu nhiên" lặp lại các mẫu từ dữ liệu huấn luyện.

- Khả năng lạm dụng: Các LLM có thể bị lợi dụng để lan truyền thông tin sai lệch, tuyên truyền hoặc tạo ra nội dung độc hại một cách hiệu quả và tự động.

Bài báo này đã châm ngòi cho cuộc tranh cãi lớn với Google và làm nổi bật những lo ngại ngày càng tăng về việc phát triển AI một cách thiếu kiểm soát.

3.4. Đạo đức AI và Tác động Xã hội

Ngoài các nghiên cứu cụ thể, Gebru còn thực hiện các nghiên cứu rộng hơn nhằm khám phá các tác động đạo đức và xã hội của công nghệ AI đối với toàn xã hội, đặc biệt là các nhóm yếu thế và bị thiệt thòi. Bà liên tục nhấn mạnh rằng AI không phải là công nghệ trung lập và có thể củng cố các bất bình đẳng hiện có nếu không được thiết kế và triển khai một cách có trách nhiệm.

Nghiên cứu của bà về dự đoán tội phạm và sự phản ánh thiên vị của con người trong học máy là một ví dụ điển hình về việc bà khám phá cách AI có thể ảnh hưởng tiêu cực đến các cộng đồng. Gebru không chỉ chỉ ra các vấn đề mà còn đề xuất các giải pháp cải thiện, bao gồm việc tăng cường sự đa dạng trong các nhóm phát triển AI, áp dụng các khung đạo đức nghiêm ngặt và thúc đẩy trách nhiệm giải trình trong ngành công nghệ.

4. Hoạt động Xã hội và Vận động

Timnit Gebru không chỉ là một nhà nghiên cứu hàng đầu mà còn là một nhà hoạt động xã hội tích cực, nỗ lực không ngừng để thúc đẩy sự đa dạng, hòa nhập và công bằng xã hội trong lĩnh vực trí tuệ nhân tạo.

4.1. Đồng sáng lập Black in AI và các hoạt động

Cùng với đồng nghiệp Rediet Abebe, Gebru đã đồng sáng lập Black in AI, một cộng đồng các nhà nghiên cứu da đen làm việc trong lĩnh vực trí tuệ nhân tạo. Mục tiêu chính của Black in AI là dân chủ hóa quyền tiếp cận lĩnh vực AI bằng cách tăng cường sự hiện diện, khả năng hiển thị và phúc lợi của các chuyên gia và nhà lãnh đạo da đen trong lĩnh vực này.

Gebru đã nhận thấy sự thiếu hụt nghiêm trọng về đa dạng trong các hội nghị AI lớn. Khi tham dự hội nghị Hệ thống xử lý thông tin thần kinh (NIPS) năm 2015 tại Montreal, Canada, bà nhận thấy mình là một trong số ít các nhà nghiên cứu da đen trong số 3.700 người tham dự. Năm sau, khi tham dự lại, bà ghi nhận chỉ có năm người đàn ông da đen và bà là người phụ nữ da đen duy nhất trong số 8.500 đại biểu. Sự thiếu đa dạng này đã thúc đẩy bà thành lập Black in AI. Kể từ năm 2017, Black in AI đã tổ chức các hội thảo tại hội nghị NIPS hàng năm, tạo ra một không gian quan trọng cho các nhà nghiên cứu da đen.

4.2. Thúc đẩy Đa dạng và Hòa nhập trong Công nghệ

Gebru là một tiếng nói mạnh mẽ trong việc thúc đẩy sự tham gia của phụ nữ và các nhóm thiểu số trong lĩnh vực STEM, đặc biệt là nghiên cứu AI. Bà đã công khai chỉ trích "văn hóa câu lạc bộ nam giới" trong ngành công nghệ và những hành vi quấy rối tình dục mà bà đã trải nghiệm tại các hội nghị.

Những trải nghiệm cá nhân của bà về phân biệt chủng tộc từ khi còn học trung học ở Hoa Kỳ, cũng như sự cố với cảnh sát đã dẫn đến việc bạn của bà bị bắt giữ thay vì được giúp đỡ, đã củng cố niềm tin của bà về sự cần thiết phải giải quyết các vấn đề đạo đức và thiên vị trong công nghệ. Bà tin rằng những trải nghiệm này là "ví dụ trắng trợn về phân biệt chủng tộc có hệ thống" và đã định hướng bà tập trung vào đạo đức công nghệ.

Sau vụ việc bà rời Google, khi các nhân viên báo cáo những phàn nàn về phân biệt chủng tộc và phân biệt giới tính với bộ phận Nhân sự, họ thường được khuyên nên nghỉ phép vì lý do y tế và tìm liệu pháp thông qua Chương trình Hỗ trợ Nhân viên (EAP) của công ty. Gebru và những người khác coi đây là sự thờ ơ và tin rằng việc bà bị sa thải là hành động trả đũa, đồng thời là bằng chứng cho thấy Google là một tổ chức có hệ thống phân biệt chủng tộc.

4.3. Phê bình TESCREAL và Đạo đức Công nghệ

Gebru, cùng với Émile P. Torres, đã đặt ra thuật ngữ viết tắt TESCREAL để chỉ trích một nhóm các triết lý vị lai trùng lặp: chủ nghĩa transhumanism, chủ nghĩa extropianism, chủ nghĩa singularitarianism, chủ nghĩa vũ trụ Nga, chủ nghĩa rationalism, chủ nghĩa vị tha hiệu quả, và longtermism.

Gebru coi những triết lý này là một ảnh hưởng cánh hữu trong các Big Tech và so sánh những người ủng hộ chúng với "những người theo thuyết ưu sinh của thế kỷ 20" trong việc tạo ra các dự án có hại nhưng lại được miêu tả là "mang lại lợi ích cho nhân loại". Bà đã chỉ trích nghiên cứu về trí tuệ nhân tạo tổng quát (AGI) là có nguồn gốc từ thuyết ưu sinh. Gebru cho rằng cần phải chuyển trọng tâm khỏi AGI và việc cố gắng xây dựng AGI là một thực hành vốn dĩ không an toàn.

5. Giải thưởng và Sự công nhận

Timnit Gebru đã nhận được nhiều giải thưởng và sự công nhận quốc tế cho những đóng góp đột phá của bà trong lĩnh vực đạo đức trí tuệ nhân tạo và công bằng xã hội.

- Năm 2019, Gebru, Joy Buolamwini và Inioluwa Deborah Raji đã giành Giải thưởng Đổi mới AI năm 2019 của VentureBeat trong hạng mục "AI vì điều tốt đẹp" cho nghiên cứu của họ làm nổi bật vấn đề đáng kể về thiên vị thuật toán trong nhận dạng khuôn mặt.

- Năm 2021, bà được tạp chí Fortune vinh danh là một trong 50 nhà lãnh đạo vĩ đại nhất thế giới.

- Cũng trong năm 2021, Gebru được đưa vào danh sách "10 người định hình khoa học" của tạp chí khoa học Nature, ghi nhận vai trò quan trọng của bà trong các phát triển khoa học.

- Năm 2022, Gebru được tạp chí Time vinh danh là một trong 100 người có ảnh hưởng nhất thế giới.

- Năm 2023, bà được Carnegie Corporation of New York vinh danh là một trong những người nhận Giải thưởng Người nhập cư vĩ đại, công nhận những đóng góp đáng kể của bà cho lĩnh vực đạo đức trí tuệ nhân tạo.

- Vào tháng 11 năm 2023, bà được đưa vào danh sách 100 Phụ nữ của BBC, là một trong những phụ nữ truyền cảm hứng và có ảnh hưởng nhất thế giới.

6. Tầm ảnh hưởng và Di sản

Tầm ảnh hưởng và di sản của Timnit Gebru đối với diễn ngôn về đạo đức AI, các thông lệ trong ngành công nghệ và các nhóm yếu thế trong lĩnh vực STEM là rất sâu rộng và lâu dài.

Công trình nghiên cứu của bà về thiên vị thuật toán, đặc biệt là dự án Gender Shades về nhận dạng khuôn mặt, đã buộc ngành công nghiệp AI phải đối mặt với những thiếu sót của mình và thúc đẩy một cuộc thảo luận quan trọng về sự công bằng và trách nhiệm giải trình. Việc bà rời Google đã trở thành một sự kiện mang tính bước ngoặt, làm nổi bật những căng thẳng giữa lợi nhuận doanh nghiệp và đạo đức nghiên cứu, đồng thời châm ngòi cho những cuộc tranh luận về tự do học thuật và quyền của người lao động trong các công ty công nghệ lớn.

Thông qua việc đồng sáng lập Black in AI, Gebru đã tạo ra một nền tảng quan trọng để tăng cường sự đa dạng và hòa nhập trong lĩnh vực AI, cung cấp sự hỗ trợ và khả năng hiển thị cho các nhà nghiên cứu da đen. Việc thành lập Viện Nghiên cứu Trí tuệ Nhân tạo Phân tán (DAIR) của bà là một bước đi táo bạo nhằm xây dựng một môi trường nghiên cứu độc lập, tập trung vào tác động của AI đối với các nhóm bị thiệt thòi, đặc biệt là ở châu Phi và cộng đồng người nhập cư châu Phi. Điều này thể hiện cam kết của bà trong việc tạo ra AI có trách nhiệm xã hội và công bằng hơn.

Quan điểm phê phán của Gebru về TESCREAL và trí tuệ nhân tạo tổng quát (AGI) đã thách thức những câu chuyện chủ đạo trong giới công nghệ, khuyến khích một cách tiếp cận thận trọng và nhân văn hơn đối với sự phát triển của AI. Di sản của bà không chỉ nằm ở những đóng góp học thuật mà còn ở vai trò là một nhà vận động kiên cường, người đã dám thách thức những gã khổng lồ công nghệ và đấu tranh cho một tương lai công nghệ công bằng và bình đẳng hơn cho tất cả mọi người.

7. Các Ấn phẩm Chọn lọc

- Gebru, Timnit (2017). Visual computational sociology: computer vision methods and challenges.

- Gebru, Timnit; Krause, Jonathan; Wang, Yilun; Chen, Duyun; Deng, Jia; Aiden, Erez Lieberman; Fei-Fei, Li (2017). "Using deep learning and Google Street View to estimate the demographic makeup of neighborhoods across the United States". Proceedings of the National Academy of Sciences.

- Buolamwini, Joy; Gebru, Timnit (2018). "Gender Shades: Intersectional Accuracy Disparities in Commercial Gender Classification". Proceedings of Machine Learning Research.

- Gebru, Timnit (2020). "Race and Gender". The Oxford Handbook of Ethics of AI.

- Gebru, Timnit; Torres, Émile P. (2024). "The TESCREAL bundle: Eugenics and the promise of utopia through artificial general intelligence". First Monday.

8. Xem thêm

- Coded Bias

- Claire Stapleton

- Meredith Whittaker

- Sophie Zhang

9. Liên kết ngoài

- [https://ai.stanford.edu/~tgebru/ Profile] tại Đại học Stanford

- [https://blackinai.github.io/ Black in AI]